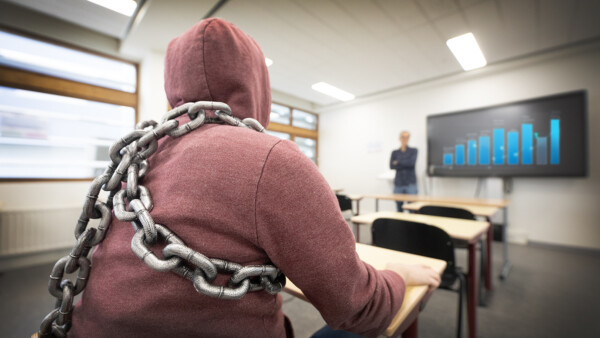

Docenten mogen geen AI-scanners inzetten, zo staat het in de AI-handreiking van de HU. Maar wat als een docent aan studenten vertelt dat zo’n scanner toch wordt ingezet? ‘Uiteindelijk ben ik mijn tekst dommer en slechter gaan herschrijven.’

Het zit Ernesto Herrera Fuentealba niet lekker. De tweedejaars journalistiekstudent aan de Hogeschool Utrecht is ervan overtuigd dat hij een lager cijfer kreeg door een AI-scanner. ‘Ze gingen er steeds meer mee dreigen: je teksten zouden door zo’n scanner gehaald worden,’ vertelt hij. ‘Je wil geen risico lopen, dus voordat je iets inlevert, haal je het er zelf maar doorheen.’

Expres slecht schrijven

De student zegt zelf geen AI te hebben gebruikt, maar zijn verslag werd door een AI-scanner aangemerkt als AI-gegenereerd. ‘Ik snapte er niks van. Uiteindelijk ben ik mijn tekst dommer en slechter gaan herschrijven.’ Het resultaat: een zes. ‘Maar anders was het sowieso een acht geweest.’

Wat vooral blijft hangen is frustratie. ‘Ik was uren aan het kloten met die AI-scanner, langer dan met het verslag zelf. Je gaat loopholes zoeken en laat expres spelfouten erin staan.’

‘Geen AI-scanners bij Journalistiek’

Een screenshot van het bericht van een docent bevestigt dat een AI-scanner meespeelde in een toets: ‘Wie AI gebruikt (en dit wordt bewezen door de AI-scanner), moet zijn werk overnieuw doen,’ schrijft een docent naar zijn studenten.

‘Wij herkennen deze beweringen niet’, zegt Pamela Wilhelmus, opleidingsmanagers bij de opleiding journalistiek aan de HU verbaasd. Ze heeft navraag gedaan bij de docenten van Herrera Fuentealba. ‘We maken in onze opleiding geen gebruik van AI-scanners en hebben dat ook nooit gedaan. En het is absoluut nooit beleid bij ons geweest.’

Niet betrouwbaar

Voor docenten klinkt het wellicht als muziek in de oren: een snelle check die uitsluitsel geeft over de herkomst van een tekst. Maar die belofte blijkt vals. Illinois State University concludeerde dat AI-scanners onbetrouwbaar zijn en adviseert docenten ze niet te gebruiken. Onderzoek waarschuwt bovendien voor precies het probleem waar Herrera Fuentealba tegenaan liep: een vals-positieve uitslag, waarbij menselijk werk onterecht als AI-gegenereerd wordt aangemerkt.

Toch schieten ‘AI-detectoren’ als paddenstoelen uit de grond. Ook Scribbr, dat ooit begon als ‘scriptie-nakijk-dienst’ biedt sinds 2024 zo’n tool aan en promoot die richting docenten met de slogan: ‘Controleer de authenticiteit van het werk van je studenten.’

Maar wat ‘authentiek’ is, verschilt per scanner. Dat merkte Herrera Fuentealba aan den lijve. ‘Mijn verslag gaf bij Scribbr nul procent AI, bij GPTZero 89 procent en bij ZeroGPT 48 procent. En hier word ik dan op afgerekend.’

Nieuwe regels

De omgang met AI aan de HU is vastgelegd in een AI-handreiking. Lange tijd richtte die zich vooral op wat studenten wel en niet mochten doen, terwijl richtlijnen voor docenten ontbraken. Sinds dit jaar is dat veranderd. In de vernieuwde handreiking staat expliciet dat scores van AI-detectiesoftware niet mogen worden gebruikt.

Die afspraak wordt ook opgenomen in toekomstige studiegidsen. ‘Beoordelingen moeten altijd worden uitgevoerd door een examinator en mogen niet worden uitbesteed aan een AI-model’, valt er te lezen.

Wat is dan de oplossing?

Als AI-scanners niet mogen, hoe controleren docenten dan de authenticiteit van studentenwerk? Volgens Herrera Fuentealba zijn er genoeg alternatieven. ‘Via Google Docs kun je zien hoe lang iemand aan een tekst werkt. Of laat studenten hun werk in tussenfases inleveren, zodat je het groeiproces ziet.’

Bij de opleiding journalistiek ligt de oplossing in de manier waarop je toetst, meent Wilhelmus. ‘We vragen studenten AI-gebruik te verantwoorden en erop te reflecteren. Daarmee leren ze niet hoe ze AI kunnen verbergen, maar hoe ze er journalistiek verantwoord mee omgaan.’

Een waterdichte oplossing zal er volgens de journalistiekstudent nooit komen. ‘Je zult AI niet volledig kunnen uitschakelen. Maar AI-scanners zijn hoe dan ook absoluut niet de oplossing.’